Tri agenta dobili su zadatak da dođu od točke A do točke B, a znanstvenike je zanimalo mogu li nagrade razviti motoričke vještine na neravnim terenima i preprekama. Zaključak - mogu!

Programi umjetne inteligencije imaju više način za za učenje novih stvari. Istraživanje koje su proveli znanstvenici DeepMinda pokazuje kako njihovi agenti samostalno uče nove stvari, a rezultati su preslatki!

Tri agenta dobili su zadatak da dođu od točke A do točke B, sa jednostavnim nagradama po putu za zadržavanje ravnoteže. Znanstvenike je zanimalo mogu li jednostavne nagrade razviti motoričke vještine na neravnim terenima i preprekama. Zaključak - mogu!

Rezultati

'Biranje kompleksnijih okolina bi moglo olakšati učenje' komentiraju znanstvenici u svom radu. Neki od zaključaka do kojih su došli i hipoteza koje su potvrdili za svakog od tri agenata:

- Planar Walker: Spontano je naučio skakati preko praznina između dvije platforme, skakati i hodati preko prepreka i saginjati se ispod platformi. Ne zezamo se. Pri samom kraju eksperimenta, Walker je mogao preskočiti preko prepreka vlastite visine.

- Quadruped: Puno drugačiji od Walkera, s obzirom na kratke noge koje mu ne omogućuju jednostavan prelazak preko čak i najjednostavnijih prepreka. No, kada se trenira na terenu koji odgovara njegovom dizajnu, kreće razvijati strategije pomoću kojih rješava prepreke. Program je terminiran kada padne sa terena.

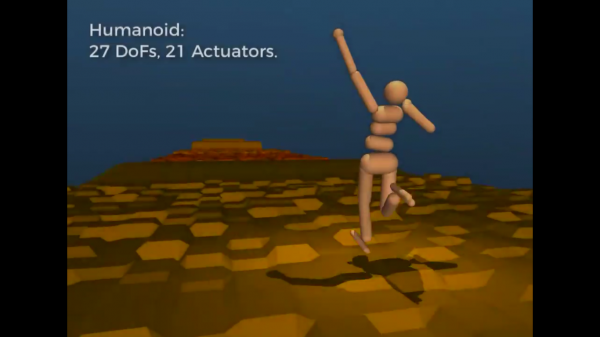

- Humanoid: Najkompleksniji od trojice. Zbog velikog broja DoFova, teže uči i drži se sigurnih algoritama pomoću kojih će proći preko terena. No s vremenom, Humanoid prolazi kroz terene kroz koje nikad nije prošao uz minimalne greške, uz dodanu vanjsku silu. Program je terminiran u dva slučaja: Kada je razmak između glave i nogu manji od 0.9 metara i kada je razmak između glave i poda manji od 1.1 metara.